Helm.ai, socio de Honda, presenta un sistema para la conducción automatizada

Según la empresa, Helm.ai Vision proporciona una percepción global mejorada, lo que reduce la necesidad de mapas HD y sensores lidar en sistemas de hasta nivel 2+, y permite una conducción automatizada de hasta nivel 3.

Eso significa que el software no es adecuado para los llamados robotaxis, que suelen funcionar en el nivel 4. Sin embargo, Helm.ai afirma que la tecnología está lista para su adopción en el mercado de masas y podría integrarse en vehículos de propiedad privada como los mencionados futuros VE de Honda.

Para aclararlo: El nivel 3, también denominado conducción altamente automatizada, permite al vehículo hacerse cargo de determinadas tareas de conducción de forma autónoma, mientras que el conductor sigue presente pero no necesita supervisar constantemente el sistema. No obstante, el conductor debe ser capaz de retomar el control a petición del sistema. Por ejemplo, Mercedes-Benz ya ofrece funciones de nivel 3 en el EQS y la Clase S con el sistema opcional Drive Pilot, que permite una conducción altamente automatizada en autopista a velocidades de hasta 95 km/h.

El nivel 2+, por el contrario, es una forma de conducción semiautomatizada que va más allá del nivel 2 al ofrecer funciones que se asemejan a las del nivel 3. Sin embargo, el conductor sigue siendo plenamente responsable de la tarea de conducción y debe supervisar el sistema en todo momento.

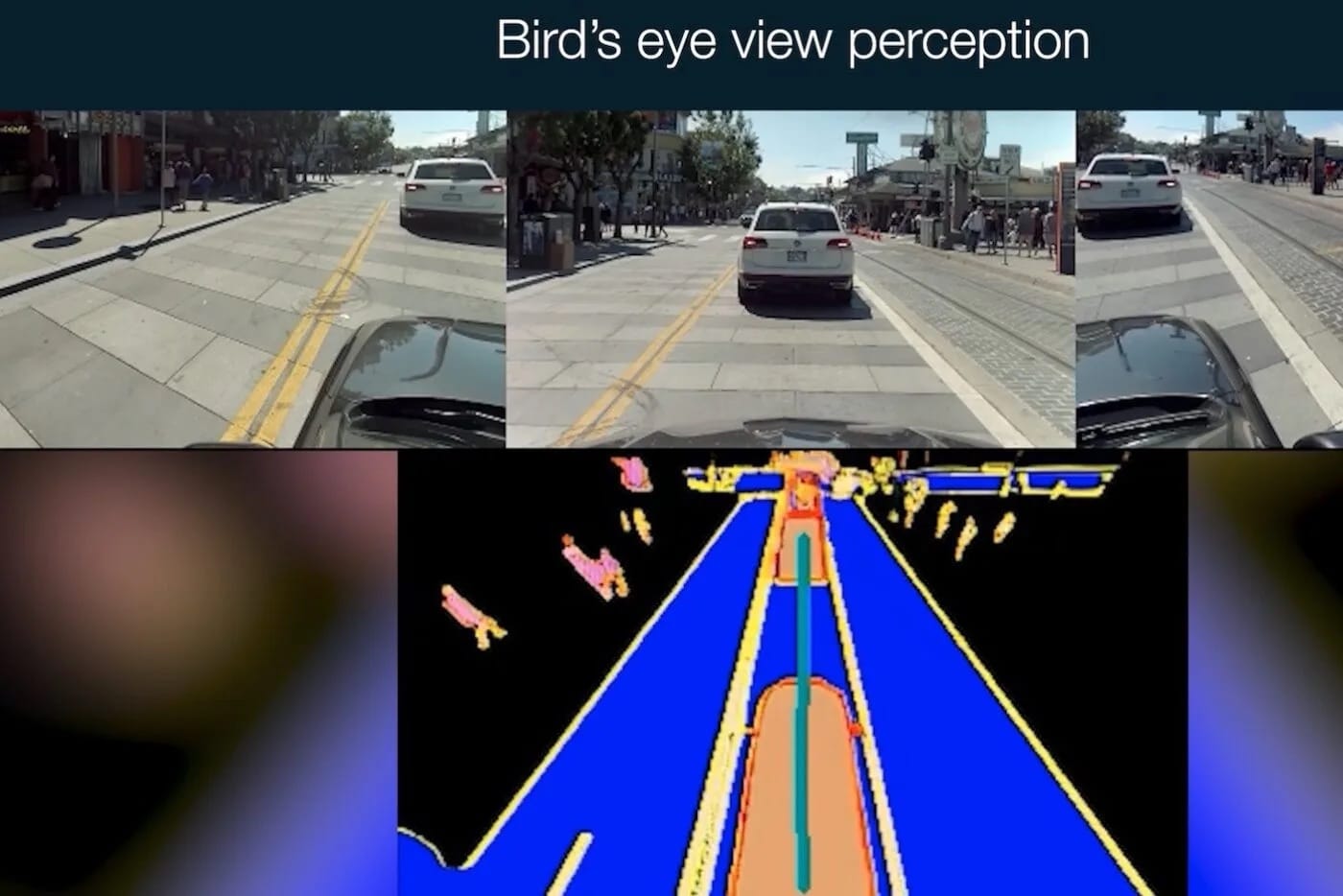

El sistema de Helm.ai emplea una tecnología propia conocida como Deep Teaching, que permite un aprendizaje exhaustivo y no supervisado a partir de datos de conducción del mundo real, reduciendo la dependencia de conjuntos de datos caros y anotados manualmente. El sistema está diseñado para interpretar las complejidades de la conducción urbana, como el tráfico denso, las condiciones variables de la carretera y el comportamiento impredecible de peatones y vehículos. Ofrece detección de objetos en 3D en tiempo real, segmentación semántica completa y fusión de vistas envolventes multicámara, lo que permite al vehículo interpretar con precisión su entorno. Además, Helm.ai Vision genera una vista de pájaro fusionando las entradas de varias cámaras en un único mapa espacial.

"La percepción urbana robusta, que culmina en la tarea de fusión BEV, es el guardián de la autonomía avanzada", afirmó Vladislav Voroninski, consejero delegado y fundador de Helm.ai. "Helm.ai Vision aborda todo el espectro de tareas de percepción necesarias para la conducción autónoma de alto nivel 2+ y 3 en sistemas embebidos de grado de producción, lo que permite a los fabricantes de automóviles desplegar una solución vision-first con alta precisión y baja latencia". A partir de Helm.ai Vision, nuestro enfoque modular de la pila de autonomía reduce sustancialmente el esfuerzo de validación y aumenta la interpretabilidad, lo que lo hace especialmente adecuado para el despliegue de producción en serie a corto plazo en vehículos definidos por software."

Según Reuters, se espera que la tecnología se implante en la nueva Serie 0 de Honda a partir de 2026. El fabricante de automóviles japonés había presentado prototipos de la serie en enero en el CES de Las Vegas. Honda es inversor en Helm.ai desde 2022. En declaraciones a la agencia de noticias, Voroninski dijo: "Definitivamente estamos en conversaciones con muchos fabricantes de equipos originales y estamos en vías de desplegar nuestra tecnología en la producción". Y añadió: "Nuestro modelo de negocio consiste esencialmente en conceder licencias de este tipo de software y también del software del modelo base a los fabricantes de automóviles."

0 Comentarios